新一代大数据与人工智能基础架构与软件开发 融合、演进与未来趋势

随着数据量的爆炸式增长和人工智能(AI)模型的日益复杂化,支撑其运行的基础架构与软件开发正经历一场深刻的范式转移。新一代技术不再将大数据处理与人工智能训练推理视为独立领域,而是致力于构建统一、高效、智能化的基础平台,以应对规模化、实时化与自动化的挑战。

一、 基础架构的融合与演进

传统的大数据基础架构(如Hadoop/Spark生态)与AI训练框架(如TensorFlow, PyTorch)往往分而治之,导致数据迁移成本高、资源利用率低。新一代基础架构的核心趋势是“融合”。

- 存算分离与统一数据湖仓:对象存储(如AWS S3, 阿里云OSS)因其无限扩展性和成本效益,正成为融合架构的事实标准存储层。在此基础上,发展出湖仓一体(Lakehouse)架构,如Databricks Delta Lake、Apache Iceberg,它们兼具数据湖的灵活性与数据仓库的管理性能,为结构化和非结构化数据提供统一的单一可信源,直接服务于AI的数据准备与特征工程。

- 异构计算与弹性调度:AI训练,尤其是大模型,极度依赖GPU、NPU等异构算力。新一代资源调度与管理平台(如Kubernetes及其生态下的KubeFlow、 Volcano)实现了对CPU、GPU、内存等资源的精细化、弹性调度,使得大数据批处理作业与AI训练任务可以在同一套资源池上混合部署,大幅提升集群整体利用率。

- 流批一体与实时智能:Flink等流处理框架定义的“流批一体”架构,使得实时数据能够被持续处理并即时用于模型更新或在线推理,推动AI从“离线学习”迈向“持续学习”和“实时决策”,在风控、推荐等场景中至关重要。

二、 人工智能基础软件的开发范式变革

在基础架构融合的推动下,AI基础软件的开发方式、工具链和核心关注点也在发生显著变化。

- 从“以模型为中心”到“以数据为中心”:Andrew Ng倡导的“以数据为中心的人工智能”理念影响深远。开发重点从一味追求模型结构创新,转向系统性提升数据质量。这催生了MLOps(机器学习运维)的蓬勃发展,其工具链(如Feast for Feature Store, Kubeflow Pipelines, MLflow)专注于数据版本管理、特征管道自动化、模型实验追踪与部署监控,确保AI项目可重复、可运维、可协作。

- 大模型时代的开发栈重塑:超大语言模型(LLM)和基础模型(Foundation Model)的出现,使得传统的从零开始训练模式不再普适。开发范式转变为:

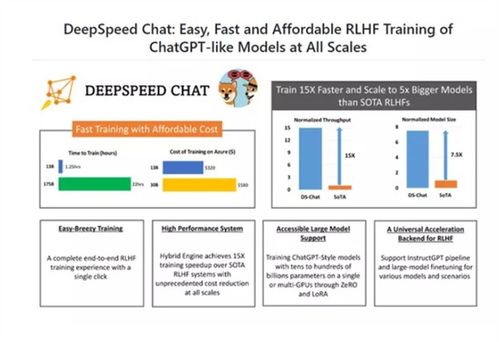

- 预训练与微调:开发者基于大规模预训练模型,使用领域特定数据进行高效微调(Fine-tuning)或提示工程(Prompt Engineering)。这降低了AI应用的门槛,也催生了像Hugging Face这样的模型中心与社区平台。

- 推理服务与优化:如何将参数量巨大的模型低成本、低延迟地部署上线成为关键。相关软件专注于模型压缩(剪枝、量化)、动态批处理、高性能推理运行时(如NVIDIA Triton, TensorRT)以及边缘推理框架的开发。

- 自动机器学习(AutoML)与低代码/无代码平台:为了进一步提升开发效率,AutoML工具(如Google Cloud AutoML, H2O.ai)尝试自动化特征工程、模型选择和超参数调优。面向业务人员的低代码AI平台,通过可视化拖拽方式构建AI工作流,正将AI能力民主化。

三、 未来趋势与挑战

技术发展将围绕以下几个关键方向深入:

- AI for System与System for AI的闭环:利用AI(特别是强化学习)来优化基础架构自身的配置、调度与故障预测(AI for System),同时设计更适配AI负载的新型硬件和系统架构(System for AI),形成良性循环。

- 隐私保护与可信AI的底层支持:联邦学习、同态加密、可信执行环境(TEE)等技术将与基础架构更深融合,在数据不出域的前提下实现联合建模与推理,满足日益严格的合规要求。

- 绿色计算与可持续发展:面对AI训练惊人的能耗,基础架构与软件将更注重能效比,通过稀疏计算、动态电压频率调整(DVFS)、以及更高效的编译器和运行时来降低碳足迹。

- 开源与标准化:开放协作仍是创新的主引擎。模型格式(如ONNX)、中间表示(如MLIR)、数据格式和接口的标准化,对于构建健康、互操作的AI生态至关重要。

新一代大数据与人工智能基础架构及软件开发,正通过深度的垂直整合与横向扩展,构建更加弹性、智能和易用的技术基座。其核心目标是打破数据、算力与算法之间的壁垒,让组织能够更敏捷地将数据洞察转化为智能行动。对于开发者和企业而言,拥抱融合架构、掌握MLOps实践、并关注大模型生态,将是驾驭下一波智能浪潮的关键能力。

如若转载,请注明出处:http://www.dzkeyun.com/product/51.html

更新时间:2026-03-03 17:12:50